Es ist das Jahr 1977. Auf einer stillen Leinwand kündigt blaue Schrift auf schwarzem Hintergrund an: „Es war einmal vor langer Zeit in einer weit, weit entfernten Galaxis…“

Dann durchbricht epische Musik die Stille und in großen gelben Buchstaben fliegt der Schriftzug „Star Wars“ in die unendlichen Weiten einer Galaxie. Die räumlich durch das Bild bewegenden Buchstaben werden musikalisch von Streichern und Trompeten unterstützt.

Ein Raumschiff, verfolgt von einem weiteren, fliegt am Zuschauer vorbei. Laserschüsse zischen durch die Dunkelheit. Das Raumschiff wird getroffen und die Szene wechselt in das getroffene Raumschiff: Durch das Bild wackelt ein Roboter, C3-PO. Science-Fiction.

Keine 40 Jahre später: Atlas, ein von Boston Dynamics entwickelter Roboter, bewegt einen „Fuß“ vor den anderen, wie 1977 C3-PO, öffnet die Tür und spaziert problemlos durch einen schneebedeckten Wald. Zurück im Raum hebt Atlas Kisten auf und stellt sie in ein Regal. Ein Mensch schlägt ihm die Kisten aus der Hand, aber geduldig hebt der Roboter die Kiste wieder auf und lässt sich nicht von seinem Ziel abbringen. Der Mensch stößt ihn sogar mit einem Besen um, doch Atlas steht auf und verfolgt weiterhin seine Aufgabe, ohne emotionale Wutausbrüche zu haben. Realität.

Die Entwicklung der Technologie schreitet rasant voran. Zwar gibt es bis dato keine straßentauglichen fliegenden Autos, aber mit dem Aeromobil 2.0 stellte eine slowakische Firma 2007 erstmals ein Modell vor, das viele Science-Fiction-Anhänger in Staunen versetzt. Einziger Nachteil: statt des Führerscheins wird ein Flugschein zur Nutzung des Produkts verlangt. Auf manche in Science Fiction Filmen vorgestellten Technologien muss aber nicht mehr verzichtet werden. Das amerikanische Unternehmen Arx Pax stellte 2014 Hendo 2.0 vor—ein Hoverboard, mit dem man wie im Film „Zurück in die Zukunft II“ von 1989, ohne Bodenkontakt fahren kann. Schwebemotoren erzeugen ein Magnetfeld und halten so das Board in der Luft — allerdings nur über einer metallischen Oberfläche. Im selben Film zieht der Hauptcharakter Marty McFly Nike Schuhe an, die sich von selbst zuschnüren. 2016 ist es tatsächlich soweit: Nike kündigt den „The Nike HyperAdapt 1.0“ an, der noch dieses Jahr verkauft werden soll und sich selbst zuschnüren kann.

Der erste Teil von „Zurück in die Zukunft“ erschien 1985 und Marty McFly reiste zurück in das Jahr 1955, wo er eine andere Welt vorfindet: Fernsehen war eine Neuheit, niemand spielt elektrische Gitarren und die Menschen haben eine andere Art, sich miteinander zu unterhalten. Würde der Film heute spielen und Marty würde ca. 30 Jahre zurück, in das Erscheinungsjahr des Filmes 1985 reisen, wären die Unterschiede erheblich größer: Es gäbe kein Internet, keine Smartphones, keine selbstfahrenden Autos und erst recht keine Roboter.

Der Fortschritt der letzten 30 Jahre (1985–2015) ist also größer als der, den es 30 Jahre zuvor gab (1955–1985). Dieses Phänomen nennt der Autor, Erfinder, Futurist, und „Director of Engineering“ (Leiter der technischen Entwicklung) bei Google, Ray Kurzweil, „Law of Accelerating Returns“. Der Fortschritt der letzten 30 Jahre war schneller, weil er in einer fortschrittlicheren Welt stattgefunden hat. Kurzweil nimmt an, dass der gesamte Fortschritt des 20. Jahrhunderts nur 20 Jahre in der Fortschrittsrate des Jahres 2000 gedauert hätte. Er vermutet außerdem, dass der Fortschritt zwischen 2000 und 2014 genau so groß ist, wie der gesamte Fortschritt des 20. Jahrhunderts. Und nur 7 Jahre später, bis 2021, noch einmal der komplette Fortschritt des 20. Jahrhunderts. Daraus schließt er, dass dieser Fortschritt (des gesamten 20. Jahrhunderts) einige Jahrzehnte später in einem Jahr, und später sogar in einem Monat stattfinden kann (Kurzweil 2005).

Eine dieser rasanten Entwicklungen ist die „Künstliche Intelligenz“ (KI). KI ist mittlerweile mehr als eine Zukunftsvision. Sie ist Realität. Und dank zunehmender Rechenleistung von Computern sogar schon in unserem Alltag integriert. Algorithmen schlagen uns vor was wir kaufen sollen (Amazon) und finden Inhalte für uns (Google). Sie verstehen gesprochene Sprache (Siri, Google Now) und sortieren Fotos nach abgebildeten Objekten für uns (Google Photos). Aber trotz der größer werdenden Präsenz im alltäglichen Leben steckt die KI noch immer in den Kinderschuhen. Technologiekonzerne investieren Unmengen in „the next big thing“. Facebook betreibt ein 50-Mann starkes KI-Labor, Google akquirierte 2014 das KI-Startup „DeepMind“ für 400 Millionen US-Dollar, deren entwickelte Künstliche Intelligenz im März 2016 den professionellen Spieler und Südkoreaner Lee Sedol in dem Spiel „Go“ schlug (Byford 2016). Und im Rahmen der Truck Platooning Challenge 2016 bewältigte eine Flotte autonom fahrender Trucks sechs großer Marken (DAF Trucks, Daimler Trucks, Iveco, MAN, Scania, Volvo) innerhalb einer Woche eine Strecke von über 2000km durch Europa.

Schon 1999 hatte Ray Kurzweil vorhergesagt, dass 2025 ein Computer mit der Leistungsfähigkeit ein menschliches Gehirn zu simulieren nur noch 1000$ kosten würde (Kurzweil 1999, 376ff). Der Weg, den der Computer noch gehen muss, um einen Steuerberater, einen Versicherungsmakler oder einen Webdesigner zu ersetzen, scheint nicht mehr weit zu sein. Künstliche neuronale Netze werden schon heute eingesetzt um beispielsweise eine Fotobibliothek in Google Photos zu sortieren. Das besondere an diesen Systemen ist, dass sie selber Erfahrungen sammeln und daraus Schlüsse ziehen. Dieses Verfahren wird maschinelles Lernen genannt. Systeme mit dieser Technologie sind bereits in der Lage zu lesen und zu schreiben (technologyreview.com, 2016), zu sprechen und zu verstehen, Dinge zu erkennen und Wissen zu integrieren (Howard 2014).

Im Rahmen der hier aufgeführten Beispiele, soll diese Arbeit den Zusammenhang zwischen dem „Law of Accelerating Returns“ und der KI untersuchen und einen Überblick über den aktuellen Stand der Forschung geben.

The Law of Accelerating Returns

Wenn Menschen an die Zukunft denken, denken sie automatisch, dass die momentane Fortschrittsrate auch auf die Zukunft zutrifft. Wenn man aber die Fortschrittsrate von Technologie in Betracht zieht, sieht man, das dieser Fortschritt sich nicht konstant entwickelt, sondern es in der Natur des Menschen liegt, sich dem Fortschritt anzupassen. Die Intuition der Menschen ist es deswegen, anzunehmen, dass der Fortschritt in der aktuellen Geschwindigkeit voran schreitet. Sogar für Menschen, die schon miterlebt haben, wie sich die Geschwindigkeit des Fortschritts erhöht, fühlt es sich an, als wäre die Geschwindigkeit konstant gewesen. Aus mathematischer Sicht kann man sagen: Wenn man eine exponentielle Kurve nah genug betrachtet, dann sieht sie aus wie eine Gerade. Obwohl also die Geschwindigkeit des Fortschritts letztes Jahr höher war, als noch vor 10 Jahren, herrschen in unseren Erinnerungen die jüngsten Erlebnisse vor. Diese Art des in die Zukunft-Sehens nennt Kurzweil die Intuitive Lineare Sicht (Kurzweil 2005).

Prognostiker ignorieren häufig diese historische exponentielle Sicht bei technologischem Fortschritt, wenn sie Prognosen über die Zukunft machen, da der Mensch dazu neigt, die Zukunft mit der Gegenwart zu vergleichen (Kurzweil 2005). Betrachtet man kürzere Zeiträume, verläuft der Fortschritt in einer S-Form, was dazu führt, dass die Betrachtung der nahen Vergangenheit zu einem verzerrten Bild führen kann. Eine neue Technologie, die auf den Markt kommt, durchläuft drei Phasen:

-

Langsames Wachstum

-

Schnelles Wachstum (die späte, explosive Phase von exponentiellem Wachstum)

-

Sättigung des Marktes

Die S-Form dieser Kurven führt dazu, dass Menschen überschätzen, was in naher Zukunft erreicht werden kann, aber unterschätzen, was in entfernter Zukunft erreicht werden kann (Kurzweil 2005).

Zwischen 1995 und 2007 befand sich das Internet in der zweiten explosiven Phase des exponentiellen Wachstums (Phase 2). Firmen wie Microsoft, Google und Facebook hielten Einzug in das öffentliche Bewusstsein. Soziale Netzwerke, Mobiltelefone und Smartphones wurden eingeführt. Der Zeitraum zwischen 2008 und 2015 bot weniger technologische Innovationen (Phase 3). Wenn man also heute jemanden nach seiner Einschätzung der Zukunft fragt, würde er die letzten Jahre als Grundlage des technologischen Fortschritts nehmen und außer acht lassen, dass die Entwicklung vielleicht gerade vor einer nächsten Innovation steht.

Ideen basieren immer auf den persönlichen Erfahrungen der Menschen, was dazu führt, dass in ihren Köpfen die Fortschrittsrate der letzten Jahre verankert ist. Die Vorstellungskraft ist ein weiterer Faktor, der dazu führt, dass Prognosen limitiert werden, da sie ebenfalls auf Erfahrungen basiert. Die Menschen erinnern sich also daran, was war, ignorieren aber die technologischen Fortschritte, die momentan um sie herum passieren.

Technologische Singularität — unsere letzte Erfindung?

Laut einer Erzählung hatte der Erfinder des Schachbretts bei seinem König eine Wunsch frei. Das Schachbrett solle mit Reiskörnern gefüllt werden. Ein Korn solle auf das erste Feld, zwei auf das zweite, vier auf das dritte, also pro Feld die doppelte Anzahl an Reiskörnern. Der König willigte sofort ein und begann die Felder dementsprechend zu füllen. Aber nach dem Erreichen der Hälfte mussten auf ein Feld bereits über 4 Milliarden Reiskörner. Und in der zweiten Hälfte des Schachbretts wurden die Zahlen absurd hoch und der König realisierte, dass er den Wunsch nicht erfüllen kann. Laut Kurzweil stehen wir genau an diesem Punkt mit der Rechenleistung. Seit den ersten programmierbaren Computern während des zweiten Weltkrieges, habe sich die Rechenleistung etwas mehr als 32 mal verdoppelt (Kurzweil 2001).

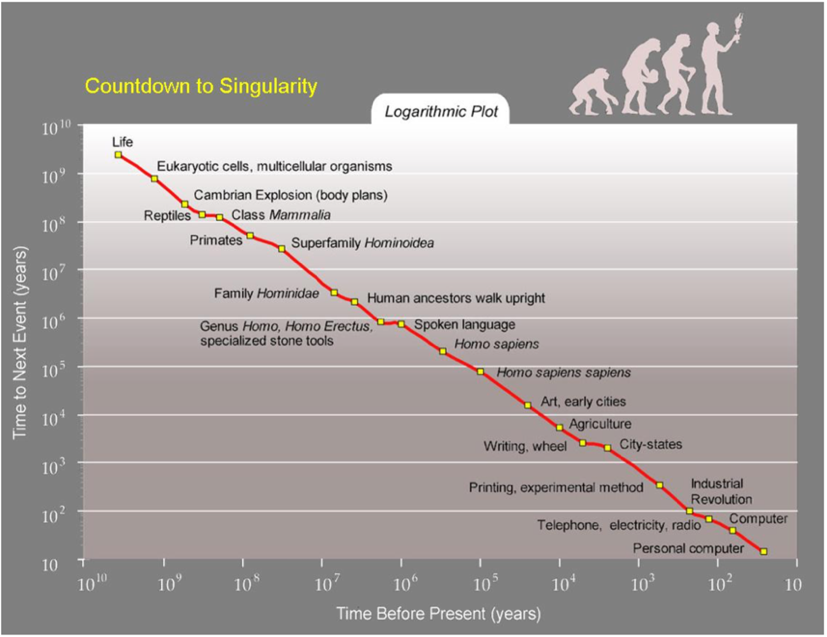

Abbildung 1 Lineare Darstellung technologischer Errungenschaften | Quelle: Kurzweil 2005

Abbildung 1 Lineare Darstellung technologischer Errungenschaften | Quelle: Kurzweil 2005

Abbildung 2 Logarithmische Darstellungen technologischer Errungenschaften | Quelle: Kurzweil 2015

Abbildung 2 Logarithmische Darstellungen technologischer Errungenschaften | Quelle: Kurzweil 2015

Obwohl Technologie sich exponentiell entwickelt, leben wir Menschen in einer linearen Welt. Technologische Trends werden nicht wahrgenommen, wenn sie sich noch unter einer gewissen Schwelle befinden. Ab einem gewissen Punkt ist die neue Technologie plötzlich da und erscheint „aus dem Nichts“. Das Internet besteht aus sogenannten Knoten (Nodes), sie Austauschpunkte für den Datenverkehr des Netzes. In den 80ern wuchs es innerhalb von 2 Jahren von 20 000 Knoten (Nodes) auf 80 000 Knoten (Nodes). Dieser Fortschritt wurde aber von der Allgemeinheit nicht wirklich wahrgenommen. 10 Jahre später wuchs das Internet von 20 000 000 auf 80 000 000 Nodes und der Effekt war bedeutend.

Wenn sich dieses potentielle Wachstum weiterhin beschleunigt, wird es in der ersten Hälfte des 21. Jahrhunderts in die Unendlichkeit wachsen. Zumindest aus der limitierten, linearen Sicht eines heutigen Menschen. Dieser Fortschritt wird so stark sein, dass er unsere Fähigkeit dem Fortschritt zu folgen überschreiten wird. Es stellt sich also die Frage: Kann die Geschwindigkeit des technologischen Fortschritts unendlich schnell werden? Und gibt es einen Punkt, an dem Menschen nicht mehr in der Lage sind schnell genug mitzudenken? Wenn es nach Kurzweil geht, können es Menschen (ohne technische Erweiterungen) nicht. Er stellt die Frage: Was könnten tausende Wissenschaftler, die tausendmal intelligenter sind und, dank ihrer nicht-biologischen Gehirne, zu tausend mal schnellerer Informationsverarbeitung fähig sind, erreichen? Ein Jahr wäre ein Jahrtausend an Fortschritt.

Wahrscheinlich würden sie Technologien entwickeln, die sie noch intelligenter machen, da ihre Intelligenz keine biologischen Grenzen hat. Sie wären eine „Superintelligenz“. Sie würden ihre eigenen Denkprozesse optimieren und wenn sie sich so weit entwickelt haben, dass sie eine Millionen Mal so intelligent sind und eine Millionen Mal schneller, wird aus einer Stunde ein Jahrhundert Fortschritt in heutiger Geschwindigkeit.

Dieser Zustand wird als Singularität bezeichnet. Singularität ist technologischer Fortschritt, der so schnell ist, dass er einen Schnitt in der Geschichte der Menschheit nach sich zieht. Es heißt, dass der Mensch mit seinem heutigen Verständnis Singularität nicht nachvollziehen kann und es unmöglich vorherzusehen ist, was nach dem Erreichen dieses Punktes geschehen wird. (Kurzweil 2001) Vernor Vinge, amerikanischer Mathematiker, Informatiker und Science-Fiction-Autor, sagte 1993, dass dieser Zustand innerhalb der nächsten 30 Jahre eintreten wird. (Vinge 1993) Schon in den 60er Jahren wird so eine „superintelligente Maschine“ von John Irving Good, einem britischen Mathematiker und Kryptologen, definiert:

„Let an ultraintelligent machine be defined as a machine that can far surpass all the intellectual activities of any man however clever. Since the design of machines is one of these intellectual activities, an ultraintelligent machine could design even better machines; there would then unquestionably be an “intelligence explosion,” and the intelligence of man would be left far behind. Thus the first ultraintelligent machine is the last invention that man need ever make, provided that the machine is docile enough to tell us how to keep it under control. … It is more probable than not that, within the twentieth century, an ultraintelligent machine will be built and that it will be the last invention that man need make.“

– Good 1965

Das Mooresche Gesetz

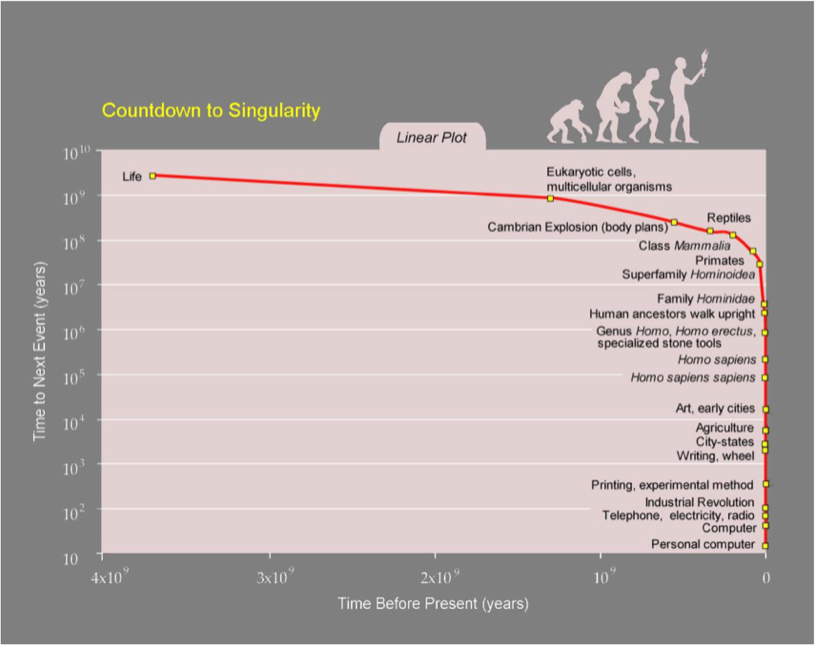

Das Mooresche Gesetz wurde 1965 von Gordon Moore, einem Mitgründer von Intel formuliert. Es besagt, dass sich die Geschwindigkeit von Prozessoren alle 18 Monate verdoppelt. Der Zeitraum für diese Verdopplung lag früher bei 2 Jahren, aber hat sich circa Anfang der 90er Jahre verkürzt. An dem Mooreschen Gesetz orientieren sich Chiphersteller bei der Entwicklung um wettbewerbsfähig zu bleiben (Bostrom 2006).

Vergleicht man die Rechenkapazität des menschlichen Gehirns, mit der Hochrechnung der Rechenleistung von Prozessoren nach dem Mooreschen Gesetz, kann man errechnen, wann Computer die grobe Rechenkapazität leisten können, um dem menschlichen Intellekt zu entsprechen. (Bostrom 2006) Aktuelle Prozessoren haben ungefähr die Rechenkapazität eines Mäusegehirns.

Das menschliche Gehirn beinhaltet 10¹¹ Neuronen. Jedes Neuron hat 5*10³ Synapsen, die mit einer Frequenz von 10² Hz Signale austauschen. Wenn jedes Signal 5 bits beinhaltet, ergibt die Rechenkapazität 10¹⁷ ops. (Moravec 1997)

Abbildung 3 Das Mooresche Gesetz | Quelle: Kurzweil 2005

Abbildung 3 Das Mooresche Gesetz | Quelle: Kurzweil 2005

Der schnellste Supercomputer in 2005 war der IBM Blue Gene/L. Dieser hatte eine Rechenkapazität von 2.6*10¹⁴ ops und hat damit Moravec’s errechnete Rechenkapazität des menschlichen Gehirns überschritten (Bostrom 2006). Trotzdem gibt es bis heute keine Superintelligenz.

Die heutigen Anwendungen, in denen Künstliche Intelligenz zum Einsatz kommt laufen mit sogenannter ANI (artifical narrow intelligence). Die Anwendungen sind Experten auf einem Gebiet, sie können zum Beispiel den Schachweltmeister schlagen, aber haben keine universelle Intelligenz. Die sogenannte „Artificial General Intelligence“ (AGI) bezeichnet die Intelligenz, auf dem Niveau des Menschen, in allen Bereichen. Diese Form der künstlichen Intelligenz wurde trotz der ausreichenden Rechenkapazität heutiger Hardware noch nicht erreicht. Der Computerwissenschaftler Donald Knuth sagt:

„I’m intrigued that AI has by now succeeded in doing essentially everything that requires “thinking” but has failed to do most of what people and animals do “without thinking” — that, somehow, is much harder! I believe the knowledge gained while building AI programs is more important than the use of the programs…“

– Bostrom 2006

Künstliche neuronale Netze

Um die Hardware wirklich intelligent zu machen, wird nicht das Wissen implizit programmiert, sondern Algorithmen, die Lernfähigkeit implementieren. Dazu wird die Funktionsweise des Gehirns rekonstruiert.

Um dies zu erreichen, wird ein Netzwerk aus Transistoren (Neuronen) hergestellt, das durch Eingänge und Ausgänge miteinander verbunden ist. Initial besitzt dieses Netzwerk kein Wissen. Es lernt durch „Trial and Error“. Wenn man dem Netzwerk zum Beispiel beibringen möchte Handschriften zu erkennen, werden die Vorschläge einfach zufällig sein. Wenn es etwas richtig macht, werden die Verbindungen der Transistoren, die zu dem richtigen Ergebnis geführt haben, gestärkt. Wenn eine Entscheidung falsch ist, werden die Verbindungen geschwächt. Nach mehreren Durchläufen, wird die Maschine für diese Aufgabe optimiert. Das menschliche Gehirn lernt auf eine ähnliche Art und Weise, deren Komplexität aber noch nicht vollends durchdrungen wurde. Bei der Untersuchung des menschlichen Gehirns werden immer wieder ausgeklügelte Mechanismen entdeckt, wie neurale Schaltmechanismen verbessert werden können.

Google bietet bereits Dienste an, die diese Technologie nutzen, zum Beispiel zur Sprach- oder Bilderkennung.

Evolutionäre Algorithmen

Ein weiterer Ansatz eine AGI (Artificial General Intelligence) zu erreichen geht davon aus, das wenn der Algorithmus, das Gehirn nachzubauen zu komplex für uns ist, ein Algorithmus entwickelt werden müsste, der die Evolution emuliert, denn die Evolution hat bereits erwiesen, in der Lage zu sein ein menschliches Gehirn zu erschaffen.

Ein Leistungs- und Evaluationsprozess verläuft bei biologischen Wesen in etwa so, dass die Leistung durch das Leben und die Evaluation erfolgt durch das erfolgreiche Fortpflanzen. Ein evolutionärer Algorithmus lässt verschiedene Computer Aufgaben lösen und die erfolgreichsten werden zusammen geführt, um bessere Computer zu erschaffen und so weiter. Es werden quasi bessere Computer durch natürliche Selektion geschaffen (Kurzweil 2005).

Superintelligenz

Nach Nick Bostrom ist eine „Superintelligenz“ ein Intellekt, der dem menschlichen Gehirn in jeder Hinsicht überlegen ist. Das bedeutet nicht nur in Rechenaufgaben überlegen zu sein, sondern in Kreativität, Weisheit und sozialen Fähigkeiten. Es ist allerdings nicht festgelegt, ob es sich dabei um einen digitalen Computer, ein Netzwerk aus Computern, oder gezüchtetes kortikales Gewebe handelt. Die Definition lässt ebenfalls offen, ob die Superintelligenz ein Bewusstsein und subjektive Erfahrungen hat.

Firmen oder wissenschaftliche Communities sind nach seiner Definition keine Superintelligenzen. Obwohl diese Entitäten viele Aufgaben bewältigen können, die ein einzelnes menschliches Gehirn nicht leisten könnte, haben sie keinen eigenen Verstand und man kann zum Beispiel nicht eine Konversation in Echtzeit mit der „wissenschaftlichen Community“, also einem Netzwerk aus Menschen, führen (Bostrom 2006).

Der Status der „Artificial Superintelligence“ ASI wird erreicht sein, sobald man AGI erreicht hat, also eine Intelligenz, die sich in allen Bereichen auf menschlichem Niveau befindet. Diese künstliche Intelligenz wäre in der Lage wieder bessere künstliche Intelligenzen zu entwickeln, was wiederum zu noch schnellerer Weiterentwicklung führen würde und so weiter.

Auch wenn man die Softwareentwicklung nicht weiter treiben würde und die Künstliche Intelligenz sich nicht weitere Fähigkeiten selbst beibringen kann, würde sie trotzdem intelligenter werden, da die Geschwindigkeit der Prozessoren sich weiterhin schneller steigert. Wenn also nach 18 Monaten die Hardware erneuert werden würde, hätte man eine Intelligenz, die doppelt so schnell denken kann, wie die ursprüngliche Implementierung und nach ein paar mehr Verdopplungen der Schaltkreise hätte man eine „schwache Superintelligenz“, eine Intelligenz mit den selben Fähigkeiten des menschlichen Gehirns, aber deutlich schneller (Bostrom 2006).

Ein weiterer Punkt, der diese Voraussage unterstützt ist, dass gelernte Fähigkeiten und kognitive Module von einer künstlichen Intelligenz zu einer anderen kopiert werden können. Wenn also eine künstliche Intelligenz einen Durchbruch in einem bestimmten Bereich schafft, können weitere künstliche Intelligenzen das Programm übernehmen und sofort über die Fähigkeit verfügen, ohne erneut den Prozess des Lernens zu durchlaufen. Was einen enormen Vorteil gegenüber biologischen Intellekten bietet. (Bostrom 2006)

Geschwindigkeit und Qualität

Wenn man an einen superintelligenten Computer denkt, denken viele an einen Roboter oder Computer, der wie ein Mensch denkt, aber dabei viel schneller ist. Nehmen wir an, die Maschine könnte in 5 Minuten den Denkfortschritt leisten, für den ein Mensch 10 Jahre bräuchte. Das klingt zwar beeindruckend, aber der wahre Unterschied der Intelligenz liegt nicht nur in der Geschwindigkeit, sondern auch in der Qualität der Intelligenz. Was einen Menschen wirklich von einem Affen unterscheidet, ist nicht die Fähigkeit schneller zu denken, sondern die Art und Weise zu denken. Die kognitiven Fähigkeiten eines Menschen erlauben ihm komplexe Kommunikation, langfristige Planung, abstraktes Denken und vieles mehr. Über diese Fähigkeiten verfügt ein Affe nicht, auch wenn man das Gehirn des Affens um das Tausendfache beschleunigen würde.

Ein Affe ist aber nicht nur unfähig, Dinge zu erreichen und begreifen, die ein Mensch erreichen und begreifen kann, er ist auch nicht in der Lage zu verstehen, dass diese höhere Intelligenz existiert. Ein Affe mag vielleicht verstehen, dass es einen Menschen gibt und dass es ein Haus gibt, aber er versteht nicht, dass der Mensch das Haus gebaut hat. Für einen Affen sind Häuser Teil der Natur. Nicht mehr und nicht weniger. Er kann nicht nur kein Haus bauen, er begreift auch nicht, dass jemand ein Haus bauen kann. Und das ist nur das Ergebnis eines „kleinen“ Unterschiedes in der Qualität der Intelligenz. Denn wenn man die aktuell existierenden Intelligenzen vergleicht, ist der Affe relativ nah an der Intelligenz eines Menschen.

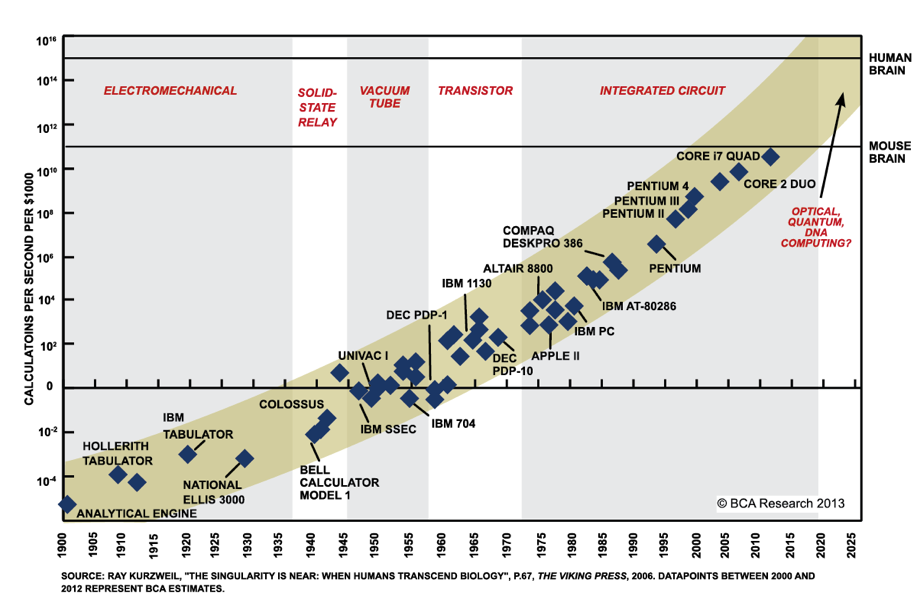

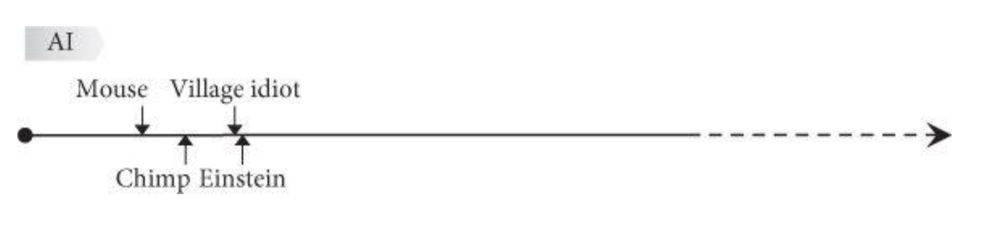

Abbildung 4 Intelligenztimeline | Quelle: Bostrom 2014

Abbildung 4 Intelligenztimeline | Quelle: Bostrom 2014

Geht man also davon aus, dass der Affe nicht mehr in der Lage ist, die Zusammenhänge zwischen Mensch und Haus zu verstehen, wird der Mensch nicht in der Lage sein, zu verstehen, was eine superintelligente Maschine zu leisten vermag. Selbst wenn die Maschine versuchen würde den Menschen Zusammenhänge zu erklären, die sie verstehen, wären die Menschen nicht in der Lage dazu.

Aufgrund der Fähigkeit, die eigene Intelligenz weiter zu entwickeln und den erläuterten Zusammenhängen des „Law of Accelerating Returns“ käme es zu einer „Intelligenzexplosion“. Eine Maschine braucht deswegen vielleicht Jahre, um von der Intelligenzqualität eines Affen auf die eines Menschen zu kommen. Aber vielleicht nur wenige Stunden, sobald sie über die Intelligenz eines Menschen hinaus ist, um gleich viele hundert Male intelligenter zu sein als ein Mensch. Und dann sogar mit jeder Sekunde unvorstellbare Schritte nach vorne machen, aufgrund der Fähigkeit sich selber intelligenter zu machen. Wenn die Nachricht kommuniziert wird, dass die erste Maschine mit der Intelligenz eines Menschen existiert, könnte die Gesellschaft unter Umständen schon zusammen mit einer Superintelligenz zusammenleben, die ihr Vorstellungsvermögen übertrifft.

Bedeutung einer Superintelligenz für die Spezies Mensch

Wenn wir uns also nicht vorstellen können, was passiert, sobald der Punkt erreicht ist, kann niemand 100%-ig vorhersagen, wie die Zukunft aussehen wird. Nick Bostrom, Oxford Philosoph und KI-Forscher, ist der Meinung, man könne die Folgen in zwei breite Kategorien aufteilen: Aussterben oder Unsterblichkeit. Wenn man die Geschichte betrachtet, tauchen neue Spezies auf, existieren für einen gewissen Zeitraum und sterben dann aus. So erging es bisher nicht nur den Dinosauriern. (Bostrom 2014)

Laut Bostrom gibt es eine Art „Life Balance Beam“, auf der einen Seite dieses Waagebalkens steht das Aussterben der Spezies, auf der anderen Seite die Unsterblichkeit. Bisher sei jedoch noch keine Spezies intelligent genug gewesen, um auf die Seite der Unsterblichkeit zu kommen. Wenn Bostrom also Recht hat, stehen wir vor zwei harten Fakten:

-

Das Auftauchen einer ASI wird das erste Mal in der Geschichte einer Spezies ermöglichen auf der Unsterblichkeitsseite des Waagebalkens zu landen.

-

Das Auftauchen einer ASI wird einen so dramatischen Einfluss auf die Menschheit haben, dass sie die Spezies Mensch auf eine der beiden Seiten des Waagebalken platzieren wird.

Dies führt automatisch zu folgenden Fragen: Wann wird es geschehen und auf welcher Seite wird die Menschheit landen?

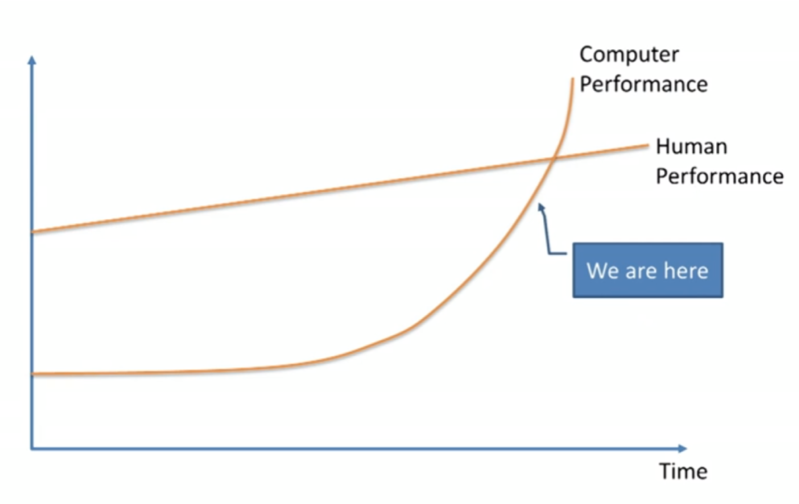

Abbildung 5: Status Quo | Quelle: Howard 2014

Abbildung 5: Status Quo | Quelle: Howard 2014

Schätzungen für die Ankunft der ASI

Professor Vernor Dinge (Dinge 1993), Wissenschaftler Ben Goertzel (Goertzel 2014), Sun Microsystems Mitgründer Bill Joy und Erfinder und Futurist Ray Kurzweil (Kurzweil 2005) und der Experte für maschinelles Lernen Jeremy Howard (Howard 2014) sind sich einig, dass wir uns kurz vor dem Erreichen dieses Status befinden.

Prominente Gegensprecher dieser Theorie sind Microsoft Mitgründer Paul Allen (Allen 2011), Psychologe Gary Marcus (Marcus 2013), Computerwissenschaftler der New York University Ernest Davis (Davis & Grishman 1986), Technologie Entrepreneur Mitch Kaper (Kapor 2002). Ihrer Meinung nach unterschätzen die Anhänger der Theorie, dass wir kurz vor dem Erreichen einer ASI wären, die Herausforderungen eine ASI zu erschaffen.

Das Lager um Kurzweil wiederum ist der Meinung, dass das Einzige, was unterschätzt werde, die Unterschätzung des exponentiellen Wachstums sei. Er vergleicht sie mit den Menschen, die 1985 das langsame Wachstums des Internets unterschätzten.

Eine dritte Meinung liefert Nick Bostrom, indem er annimmt, dass beide Lager richtig liegen und man es zwar nicht vorhersehen könne, aber es durchaus in naher Zukunft soweit sein könnte. (Bostrom 2014)

Und natürlich gibt es auch Vertreter der Meinung, dass so etwas wie eine Grenze zur AGI bzw. HLMI (Human-Level Machine Intelligence) nie erreicht werden würde, zum Beispiel den Philosophen Hubert Dreyfus (Dreyfus 1992).

Um diese unterschiedlichen Meinungen unter einen Hut zu bekommen, haben Vincent C. Müller und Nick Bostrom 2013 eine Umfrage auf Fachkonferenzen mit folgender Frage durchgeführt: „Angenommen, die menschliche wissenschaftliche Forschung wird weiterhin fortgeführt, ohne bedeutende Unterbrechungen. In welchem Jahr würden Sie annehmen, dass zu einer 10%igen, 50%igen und 90%igen Wahrscheinlichkeit eine Human-Level-Machine-Intelligence existieren wird?“ (Bostrom & Müller 2014) Die Teilnehmer sollten ein optimistisches Jahr (mit einer 10%igen Wahrscheinlichkeit einer AGI), eine realistische Schätzung (50%ige Wahrscheinlichkeit einer AGI) und eine sichere Schätzung (90%ige Wahrscheinlichkeit einer AGI) nennen. Folgendes waren die Ergebnisse:

- Mittleres optimistisches Jahr (10% Wahrscheinlichkeit): 2022

- Mittleres realistisches Jahr (50% Wahrscheinlichkeit): 2040

- Mittleres pessimistisches Jahr (90% Wahrscheinlichkeit): 2075

Im Mittel sagen die Teilnehmer also, dass es wahrscheinlicher ist, dass in circa 25 Jahren eine AGI existiert, als das keine existiert. Ist man jetzt noch ein Teenager, sagt einem die Gruppe von KI-Experten voraus, dass man noch Zeuge einer AGI werden wird.

Außerdem fragten Müller und Bostrom die Experten, wann ihrer Meinung nach eine ASI erreicht werden würde: Zwei Jahre nach dem Erreichen der AGI oder 30 Jahre nach der AGI?

Die Ergebnisse ergaben eine 10%ige Wahrscheinlichkeit für das Erreichen einer ASI zwei Jahre nach der AGI, also einer sogenannten Intelligenzexplosion, und einem langsameren Übergang von 30 Jahren oder weniger sprachen die Experten eine 75%ige Wahrscheinlichkeit aus . (Bostrom & Müller 2014)

Die Zahlen sind nicht wirklich aussagekräftig, aber wenn man ein Mittel für den Sprung von AGI zur ASI um die 20 Jahre annimmt, wären die ungefähren Vorhersagen der Experten für eine ASI:

2040 für eine AGI und 2060 für das Erreichen einer ASI.

ASI — Bedrohung oder Hilfe für die Spezies Mensch?

Die zweite Frage, die an dieser Stelle gestellt werden muss, ist: Auf welcher Seite des Life-Balance-Beams wird die Menschheit landen? Aussterben oder Unsterblichkeit. Da eine Superintelligenz eine unvorstellbare Macht mit sich bringen würde, formuliert sich die Frage: Wer kontrolliert diese Macht und was ist die Motivation einer Superintelligenz?

Diese Frage wird in der Expertengruppe heiß diskutiert. Die Umfrage von Müller und Bostrom ergab, dass eine AGI mit 52%iger Wahrscheinlichkeit einen eher positiven oder extrem positiven Effekt auf die Menschheit haben wird und eine 31%ige Wahrscheinlichkeit dafür, dass die Folgen eher schlecht oder extrem schlecht sein werden. Nur 17% entschieden sich für ein neutrales Ergebnis (Bostrom & Müller 2014). Die große Mehrheit der Experten ist sich also sicher, dass — egal ob positiv oder negativ — das Eintreten einer AGI einen großen Einfluss auf die Menschheit haben wird. Dadurch lässt sich davon ausgehen, dass der Effekt einer ASI zu einem weit weniger „neutralen“ Ergebnis geführt hätte.

Festzuhalten bleibt: Die meisten Experten sind der Meinung, dass ASI wahrscheinlich erreicht wird, und zwar wahrscheinlich innerhalb des 21. Jahrhunderts und wahrscheinlich wird es einen riesigen Einfluss auf die Menschheit haben, wenn es soweit ist.

Es wird wahrscheinlich noch in diesem Jahrhundert eine Superintelligenz existieren.

Warum ASI eine Hilfe für die Spezies Mensch sein könnte

Nick Bostrom nennt drei Richtungen, in die eine Superintelligenz funktionieren könnte und nutzt als beispielhaftes Problem, die Weiterentwicklung des Motors:

-

Als Orakel, welches nahezu alle (komplexen) Fragen einwandfrei beantwortet, die die Menschen aktuell nicht einfach so beantworten können. Das Orakel beantwortet Fragen wie: „Wie kann ich einen effektiveren Motor bauen?“ Google wird als primitive Form eines Orakels genannt.

-

Als Genie, welches jeden Auftrag auf höchstem Niveau erfüllt. Zum Beispiel ein neues Werkzeug zu entwickeln, um einen neuen effektiveren Motor zu erschaffen. Danach wird es auf den nächsten Auftrag warten.

-

Als übergeordnetes Wesen, welches höhere Ziele anstrebt und die Möglichkeit hat, frei in der Welt zu operieren. Es entscheidet selber, welches der beste Weg ist, eine schnellere, günstigere und sichere Methode für den privaten Personentransport zu entwickeln.

Kurzweil glaubt daran, dass Computer AGI in 2029 erreicht haben und 2045 nicht nur ASI existieren wird, sondern eine komplett neue Welt entsteht — diese Welt nennt er „Singularität“ (Kurzweil 2005). Seine Vorstellung der Zeitspanne wurde als extrem überzogen empfunden und wird auch von einigen weiterhin als unrealistisch bezeichnet. Mitchell Kapor, US-amerikanischer Softwareentwickler und IT-Unternehmer hat sogar 20 000 $ gegen Kurzweils Vorhersage gewettet. Aber die Umfragewerte von Müller und Bostrom sind schon relativ nah, an Kurzweils Vorhersage gerückt (AGI: 2040, ASI: 2060).

Kurzweil begründet seine Vorhersagen mit drei Revolutionen in den Bereichen Biotechnologie, Nanotechnologie und der künstlichen Intelligenz (Kurweil 2005).

Exkurs: Nanotechnologie

Nanotechnologie wird für Technologien verwendet, die Materie in der Größenordnung 1 bis 100 Nanometer manipulieren kann. Ein Nanometer ist ein millionstel eines Millimeters. Das heißt, es können Manipulationen an Viren (ca. 100nm), DNA (10nm) oder Molekülen wie Glukose (1nm) vorgenommen werden. Der nächstgrößere Schritt wäre die Manipulation von Atomen, die kleiner sind als circa 0,1 nm (Kurzweil 2005). Nanotechnologie wird heute schon eingesetzt, um beispielsweise Lebensmittel haltbarer zu machen oder Materialien zu beschichten.

Mit molekularer Nanotechnologie kann Materie wie ein Baukastenprinzip zusammengesetzt werden. Das bedeutet, jede Struktur kann nachgebaut werden. Der amerikanische Ingenieur Eric Drexler versteht unter molekularer Nanotechnologie die digitale, programmierbare Manipulation der Materie auf atomarer Ebene und die daraus resultierende Fertigung (Drexler 1986).

So weit ist die Entwicklung der Nanotechnologie noch nicht, aber Kurzweil sagt voraus, dass wir circa 2020 in der Lage sein werden, Materialien mit Nanotechnologie nachzubauen. (Kurzweil 2005) Die USA, die EU und Japan haben zusammen bereits circa 5 Milliarden Dollar in die Erforschung der Technologie investiert.

Was eine Superintelligenz mit so einem Nanoassembler erschaffen könnte wäre gigantisch. Aber Nanotechnologie ist etwas, das der Mensch erfunden hat — was würde eine ASI erfinden? Die ASI könnte Technologien entwickeln, die unsere Vorstellungskraft weit überschreiten.

Mit ASI zur Unsterblichkeit

Mithilfe von Nanotechnologie, Biotechnologie und ASI wäre es nach Kurzweil möglich, den Alterungsprozess des menschlichen Körpers zu unterbrechen. Unter anderem nennt Kurzweil als Möglichkeit mit Wifi ausgestattete Nanoroboter, die in unserer Blutlaufbahn unterwegs sind und kontinuierlich Zellen reparieren oder ersetzen. Auch Verjüngung wäre möglich: Man könne z.B. den Körper eines 60-jährigen wieder auf den Stand eines 30-jährigen „reparieren“, denn die Unterschiede, sind eigentlich nichts anderes als physikalische Gegebenheiten, die mit der entsprechenden Technologie manipuliert werden können. Der Körper besteht aus Atomen und wenn eine ASI die Zusammenhänge erkennen und auf atomarer Ebene manipulieren kann, wäre diese Vorgehensweise theoretisch machbar.

Oder mit den Worten von Nick Bostrom:

„It is hard to think of any problem that a superintelligence could not either solve or at least help us solve. Disease, poverty, environmental destruction, unnecessary suffering of all kinds: these are things that a superintelligence equipped with advanced nanotechnology would be capable of eliminating. Additionally, a superintelligence could give us indefinite lifespan, either by stopping and reversing the aging process through the use of nanomedicine, or by offering us the option to upload ourselves. A superintelligence could also create opportunities for us to vastly increase our own intellectual and emotional capabilities, and it could assist us in creating a highly appealing experiential world in which we could live lives devoted to joyful game-playing, relating to each other, experiencing, personal growth, and to living closer to our ideals.“

– Bostrom 2003

Diese Seite der Medaille klingt verlockend und die Zukunft scheint in sicheren Händen zu liegen. Wie kommt es also, dass Bill Gates „nicht versteht, wie die Leute nicht besorgt sein können“, Elon Musk künstliche Intelligenz für „die größte existentielle Bedrohung“ hält und Steven Hawking vor „dem Ende der Menschheit“ warnt.

“Artificial intelligence is our biggest existential threat” — Elon Musk

ASI als letzte Erfindung

Die Entwicklung der Technologie wird etwas erschaffen, das alles ändern wird, aber in einem Gebiet, das der Menscheit noch gänzlich unbekannt ist. Nick Bostrom beunruhigt, dass das Erschaffen von etwas, das intelligenter als man selber ist, ein fundamentaler Darwinistischer Fehler ist und vergleicht die Situation mit Spatzen, die eine Babyeule adoptieren, damit diese, sobald sie aufgewachsen ist, die Spatzenfamilie beschützt und ihr hilft. Gleichzeitig ignorieren diese Spatzen die skeptischen Spatzen, die bezweifeln, ob dies eine gute Idee ist (Bostrom 2014).

Die Ängste vor einer ASI liegen auf der Hand: Eine ASI kann für hohe Arbeitslosigkeit sorgen, weil die menschliche Arbeit nicht mehr benötigt wird. Wenn Menschen unsterblich sind, wo sollen sie alle leben? Aber die größte Angst ist die existentielle Angst.

Auch hier sind die negativen Szenarien schnell in den Köpfen: Ein Regime oder eine Terrororganisation kommt in die Hände der Technologie oder die Handlung von vielen Science-Fiction filmen: eine ASI wird entwickelt und entscheidet sich dazu, sich gegen ihren Erfinder zu stellen und die Menschheit auszulöschen. Das Problem hierbei: Die Eigenschaft „böse“ ist ein menschliches Konzept und einer KI zu unterstellen, sie sei „böse“ wäre Anthropomorphisierung. Anthropomorphisierung ist ein weiteres Problem, wenn über eine ASI nachgedacht wird, dies soll aber an dieser Stelle nicht weiter behandelt werden, da es über den Rahmen der Hausarbeit hinaus geht. Theoretisch könnte es sogar sein, dass bereits eine ASI existiert, wir aber noch nichts von ihr wissen, denn als kognitive Fähigkeiten einer Superintelligenz zählt Bostrom u.a.:

-

Intelligenzssteigerung: Der Computer wird gut darin, sich selber intelligenter zu machen.

-

Strategien entwickeln: Der Computer kann strategische, analytische und lange im Voraus planen und weniger intelligente Wesen überlisten.

-

Soziale Manipulation: Die Maschine kann Leute manipulieren.

-

Weitere Fähigkeiten sind coding, hacking, Manipulation des Finanzsystems, etc.

(Bostrom 2014)

Fazit

Heute klingen Nachrichten wie „Russischer Roboter flüchtet aus Labor“ eher wie eine lustige Randnotiz. Das liegt daran, dass es sich in der heutigen Welt noch um Maschinen mit relativ geringer Intelligenz handelt. Es sieht eher aus wie der Dorftrottel, der sich ungestüm durch die Gegend bewegt als eine ernsthafte Bedrohung. Aber der Punkt ist: Vom Dorftrottel bis zu Albert Einstein ist es auf der Intelligenzskala nur ein minimaler Sprung.

Spannend ist, dass sich ein Großteil der Forscher einig ist, dass die Menschheit nah vor einer Revolution steht, deren Dimensionen unsere Vorstellungskraft überschreitet. Eine Revolution, die alle anderen Forschungsfragen überflüssig machen würde. Der Forschungsbereich beruht vielmehr auf Spekulationen als auf harten Fakten. Daher ist es schwierig genaue Aussagen zu treffen. Fakt ist aber: Die Entwicklungen im Bereich der KI gehen rasant voran und es gibt viele offene Fragen. Zum Beispiel, ob die Software „Open Source“ entwickelt werden sollte, mit der Gefahr, dass z.B. Terroristen den Sourcecode benutzen könnten oder abgeschottet von der Öffentlichkeit, was bedeuten würde, dass eine Firma oder eine Regierung in den Besitz einer AGI kommen könnte. Was danach passiert kann nur spekulativ betrachtet werden, da niemand weiß in welcher Form eine Superintelligenz handeln und sogar welche „Form“ die Intelligenz annehmen würde.

Das erschaffen einer ASI wird oft als „die letzte Erfindung, die wir jemals machen werden“ bezeichnet. Und ob das Ergebnis positiv oder negativ sein wird, ist nicht vorhersehbar. Die Forschung in diesem Bereich ist hoch interessant und niemand scheint sich den Konsequenzen entziehen zu können, sobald es so weit ist. Viele Science-Fiction Filme wirken gar nicht mehr so unrealistisch, wenn man sich genauer mit dem Thema auseinander setzt. Und während wir uns auf unserem Tatooine über vermeitliche Belanglosigkeiten streiten, bastelt ein Galen Erso an einer Erfindung, die alle anderen obsolet macht, wir wissen oder glauben es nur noch nicht.

Quellen:

Allen, P., 2011. The Singularity Isn’t Near. 12.10.2011. Available at: Link [Accessed July 4, 2016].

Barfield, W., 2015. Cyber-Humans, Springer International Publishing Switzerland.

Barrat, J., 2013. Our Final Invention: Artificial Intelligence and the End of the Human Era, St. Martin’s Press.

Bostrom, N., 2014. Superintelligence, Oxford University Press.

Bostrom, N., 2006. How Long Before Superintelligence? International Journal of Futures Studies, 5(1997), pp.11–30. Available at: Link

Bostrom, N., 2003. Ethical Issues in Advanced Artificial Intelligence. Cognitive, Emotive and Ethical Aspects of Decision Making in Humans and in Artificial Intelligence, Vol. 2, ed. I. Smit et al., Int. Institute of Advanced Studies in Systems Research and Cybernetics, 2003, pp. 12–17]. Available at: Link [Accessed July 5, 2016].

Bostrom, N. & Müller, V., 2014. Future Progress in Artificial Intelligence : A Survey of Expert Opinion. , (forthcoming).

Davis, E. & Grishman, R., 1986. AI Research in Progress at the Courant Institute , New York University. AI Magazine, 7(5), pp.82–86.

Drexler, E., 1986. Engines of Creation, Anchor Books.

Dreyfus, H., 1992. What Computers Still Can’t Do: A Critique of Artificial Reason, The MIT Press.

Goertzel, B., 2016. Superintelligence : Fears , Promises and Potentials.

Goertzel, B., 2014. Ten Years To The Singularity If We Really Really Try.

Good, I.J., 1965. Speculations Concerning the First Ultraintelligent Machine.

Helm, L., 2013. Will Advanced AI Be Our Final Invention? 14.12.2013. Available at: Link [Accessed July 5, 2016].

Howard, J., 2014. The wonderful and terrifying implications of computers that can learn. Dezember 2014. Available at: Link [Accessed May 3, 2016].

Joy, B., 2000. Why the Future Doesn’t Need Us. 04.01.2000. Available at: Link [Accessed July 4, 2016].

Kapor, M., 2002. By 2029 no computer — or machine intelligence — will have passed the Turing Test. Available at: Link [Accessed July 4, 2016].

Kurzweil, R., 2005. The Singularity Is Near, Penguin Books Ltd.

Kurzweil, R., 2011. Kurzweil Responds: Don’t Underestimate the Singularity. 20.10.2011. Available at: Link [Accessed July 4, 2016].

Kurzweil, R., 2001. The Law of Accelerating Returns. 07.03.2001. Available at: Link [Accessed June 7, 2016].

Marcus, G., HYPING ARTIFICIAL INTELLIGENCE, YET AGAIN. 31.12.2013. Available at: Link [Accessed July 4, 2016].

Mateosian, R., 2006. The future will soon be here The Singularity is Near. , pp.141–142.

Moravec, H., 1997. Brains , Eyes and Computers.

Nilsson, N.J., 2010. THE QUEST FOR ARTIFICIAL INTELLIGENCE, Cambridge University Press.

Potts, M., 1983. Looking into the future. Planned parenthood review, 3(2), pp.3–5.

Prescott, T.J., 2013. The AI singularity and runaway human intelligence. Lecture Notes in Computer Science (including subseries Lecture Notes in Artificial Intelligence and Lecture Notes in Bioinformatics), 8064 LNAI, pp.438–440.

Sahin, E., 2001. The Machine Age.

Vinck, D., 2012. Thinking about Technology. Université de Technologie de Belfort-Montbéliard, pp.127–143.

Vinge, V., 1993. The Coming Technological Singularity: How to Survive in the Post-Human Era. , pp.1–10.

Watson, R., 2014. 50 Schlüsselideen der Zukunft. 50 Schlüsselideen der Zukunft, pp.76–79.

Credits für die Inspiration an:

Wait But Why.com